Data ja automaatio

Datan hankinta ja käsittely haukkaan usein liian suuren palan työajasta. Emme halua, että asiakkaillemme arvokas paikkatieto ja muu data jää hyödyntämättä, koska sen käyttöön saaminen on hankalaa tai liian aikaa vievää.

Tarjoammekin välineitä, joiden avulla voitte käyttää aikanne siihen mihin se kannattaakin – tiedon hyödyntämiseen sen kokoamisen ja käsittelyn sijaan.

Datan ja automaation ratkaisujen kehittämisen saralla voidaan tunnistaa tyypilliset työvaiheet, joista kaikkiin tarjoamme ratkaisuja:

- Tutkimuskysymyksen asettelu: Mihin kysymykseen tai ongelmaan tiedon avulla halutaan vastata?

- Tietojen kartoitus: Mitä tietoa on olemassa, tai tarvitaan lisäksi? Onko tieto laadullisesti soveltuvaa ongelman ratkaisun näkökulmasta, vai onko sille tehtävä jotakin?

- Tiedonkäsittelyn suunnittelu: Millä tavalla tietoa tulisi käsitellä, jotta sitä voidaan käyttää tunnistettuun tarpeeseen? Tuleeko tietoa korjata, täydentää, muuttaa, yhdistellä, tai jalostaa? Minkälainen tietovarasto ratkaisulle on käytettävissä?

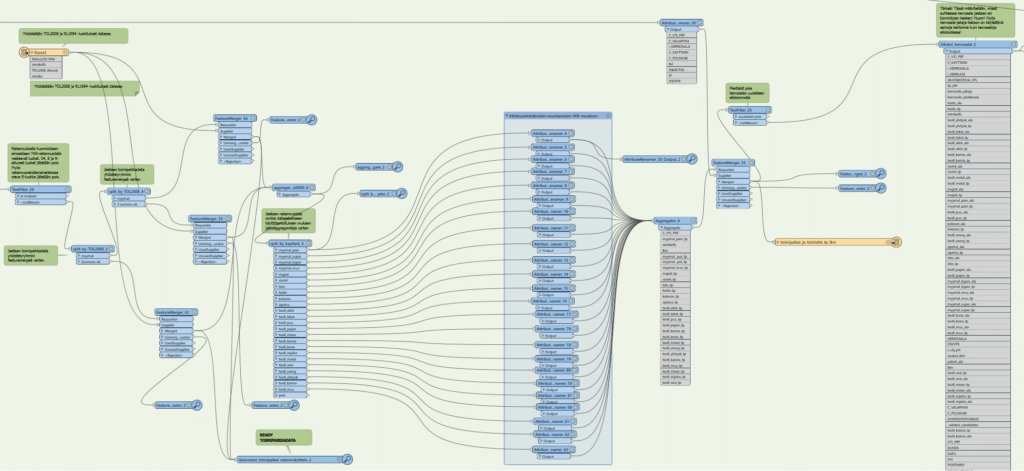

- Automaattisen tietojenkäsittelyn toteutus ja testaus: Dataputkien, ETL- tai ELT-prosessien toteutus. Usein toteutuksen aikana eteen tulee pulmatilanteita, joissa tehtyä suunnitelmaa joudutaan vielä iteroimaan. Testausta ja validointia kannattaa tehdä runsaasti, koska mahdolliset poikkeamat ja reunatapaukset erottuvat yleensä vasta suuremmista aineistomassoista.

- Tiedon analysointi: Usein tiedon käsittelyn jälkeen tai osana sitä prosessiin halutaan rakentaa automatisoituna vielä varsinaiseen tutkimuskysymykseen vastaaminen, eli hyödynnetään edellä käsiteltyä tietoa esimerkiksi osana algoritmia, joka pyrkii löytämään vastauksen esitettyyn ongelmaan.

- Tiedon visualisointi ja johtopäätösten luominen: Kun tiedot on käsitelty ja analysoitu, tehokas johtopäätöksistä viestiminen edellyttää yleensä selkeiden raportoinnin ratkaisujen toteuttamista.

Repertuaariimme kuuluvat monen tyyppiset automaattiset datankeruu- ja jalostusratkaisut (esim. ETL ja ELT), jotka lukevat ja käsittelevät tietokannoista, rajapinnoista ja muista aineistolähteistä dataa suoraan asiakkaidemme käyttöön. Välineet valitsemme aina tapauskohtaisesti, mutta suuressa suosiossamme ovat viime aikoina olleet muun muassa FME, Databricks, Snowflake, Apache Spark, PostGIS, Azure Data Factory, Python, pyqgis, sekä R.

Varmistaaksemme datan virtauksen asiakasorganisaation sisällä ja tarvittaessa myös ulospäin sidosryhmille tai avoimesti julkiselle yleisölle, luomme OGC-standardien mukaiset rajapintapalvelut (esim. WFS, OGC API Features, WMS, WMTS, MVT) tietoa jakelemaan.

Viimeisenä silauksena kokonaisuudelle integroimme laatimamme tiedonkäsittelyputket asiakkaan raportointiympäristöön valmiiksi pureskeltuina tiedon visualisointeina, oli kyseessä sitten esimerkiksi tiedolla johtamisen välineistöä kuten PowerBI tai Tableau, tai paikkatietojärjestelmään kuten QGIS:iin rakennettu työtila.